消化器病専門医および消化管内視鏡専門医の立場から、提供された文献に基づき、大腸内視鏡によるポリペクトミー後のサーベイランス(経過観察)方針についてまとめます。

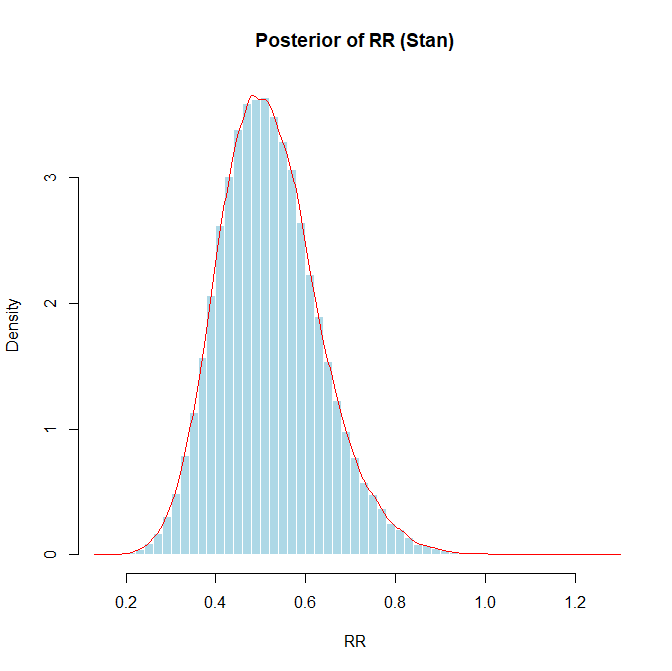

サーベイランスの間隔は、初回内視鏡(ベースライン)で見つかったポリープの数、大きさ、組織型(腺腫か鋸歯状病変か)、および異形成の程度に基づく「リスク層別化」によって決定することが国際的なコンセンサスとなっています。

1. リスク層別化に基づくサーベイランス間隔

#低リスク群(Low Risk)

一般的に、少数の小さな腺腫のみが見つかった場合が該当します。

定義: 1~2個の管状腺腫で、大きさが10mm未満、かつ高度異形成(high-grade dysplasia)を伴わないもの。

推奨間隔: 多くのガイドラインでは、5年から10年後のサーベイランス、あるいはサーベイランスを行わず各国のスクリーニングプログラム(便潜血検査など)への復帰を推奨しています。

根拠: 低リスク腺腫切除後の進行性腫瘍(Advanced Neoplasia)の発生リスクは、ポリープがなかった群と比較して同等か、わずかに高い程度であり、頻繁な検査は不要とされています。米国(USMSTF)のガイドラインでは5~10年後、欧州(ESGE)や英国(BSG)のガイドラインでは、スクリーニングプログラムへの参加または10年後の大腸鏡が推奨されています。

微小ポリープの扱い: 5mm以下の微小腺腫(diminutive adenoma)と6-9mmの小腺腫(small adenoma)では、6-9mmの方が異時性進行病変のリスクが高いというデータがあり、微小腺腫のみの場合は間隔を延ばすことが検討されています。

#高リスク群(High Risk / Intermediate Risk)

進行した腺腫や多数の腺腫が見つかった場合が該当します。

定義:

進行腺腫(Advanced Adenoma):大きさが10mm以上、絨毛成分を含む、または高度異形成を伴うもの。

多発腺腫:ガイドラインにより定義が異なりますが、通常3個以上、あるいは5個以上の腺腫がある場合。

推奨間隔: 一般的に3年後のサーベイランスが推奨されます。

根拠: 高リスク腺腫(進行腺腫や多発腺腫)を有する患者は、将来的に進行性腫瘍や大腸癌が発生するリスクが有意に高いため、より短い間隔でのサーベイランスが必要です。

超高リスク: 10個以上の腺腫がある場合は、遺伝性疾患(家族性大腸腺腫症など)の可能性を考慮し、遺伝カウンセリングへの紹介や、より頻繁なサーベイランス(例:1年未満)が推奨されることがあります。

2. 鋸歯状病変(Serrated Polyps)のサーベイランス

近年、鋸歯状病変経路(serrated pathway)による発癌リスクが注目されており、これらの病変に対するサーベイランスも規定されています。

低リスク: 10mm未満の過形成性ポリープ(特に直腸S状結腸)や、異形成のないsessile serrated lesion (SSL) は低リスクとみなされ、10年後などの長期サーベイランスまたはスクリーニング復帰が推奨されます。

高リスク: 10mm以上の鋸歯状病変、または異形成を伴う鋸歯状病変(Traditional Serrated Adenomaを含む)は高リスクとみなされ、3年後のサーベイランスが推奨されます。

また、鋸歯状病変と通常の腺腫が併存する場合、進行腫瘍のリスクが増加するため、注意が必要です。

3. 分割切除(Piecemeal Resection)後のサーベイランス

20mmを超える大きな病変を内視鏡的粘膜切除術(EMR)などで分割切除した場合、局所再発のリスクが高くなります。

推奨方針: 切除から約6ヶ月後に最初のサーベイランス(SC1)を行い、遺残・再発がないか確認する必要があります。

長期経過: 最初のサーベイランスで再発がなければ、その後は1年後、3年後といった間隔で慎重に経過観察を行います。術後の熱凝固(スネアチップソフト凝固など)やクリップ閉鎖が再発率低下に寄与する可能性があります。

4. 大腸癌切除後のサーベイランス

大腸癌の根治切除後の患者も、異時性病変や局所再発のリスクがあるためサーベイランスが必要です。

推奨間隔: 術後1年後に大腸内視鏡を行い、異常がなければ次は3年後、その次は5年後と間隔を空けていくのが一般的です。

術前検査: 術前に閉塞などで全大腸の観察ができていない場合は、術後3~6ヶ月以内に残存結腸の検査を行うべきです。

5. その他の重要な考慮事項

腸管前処置(Bowel Preparation): 前処置が不良(Poor/Inadequate)で観察不十分な場合は、ガイドライン通りの間隔ではなく、1年以内など早期の再検査が必要です。

年齢と健康状態:

若年者(50歳未満): 若年で腺腫が見つかった場合でも、50歳以上と同様のリスク層別化に基づくサーベイランス間隔(低リスクなら5年、高リスクなら3年)が妥当であるという報告があります。

高齢者(75-80歳以上): 期待余命や併存疾患を考慮し、サーベイランスの中止を個別に検討すべきです。

検査の質(Quality of Colonoscopy): 腺腫発見率(ADR)が高い内視鏡医による検査や、適切な抜去時間(6分以上)の確保は、中間期癌のリスクを低減させるため、サーベイランス間隔の決定において前提となります。

まとめ

ポリペクトミー後のサーベイランスは、一律ではなく「リスクに応じた(Risk-stratified)」アプローチが必須です。

1. 低リスク(1-2個の<10mm管状腺腫): 5~10年後(またはスクリーニング復帰)。

2. 高リスク(≧3個、≧10mm、高度異形成/絨毛成分、または高リスク鋸歯状病変): 3年後。

3. 不完全切除・分割切除後: 6ヶ月後。

4. 大腸癌術後: 1年後。

これらの方針は、無駄な検査を減らしつつ、大腸癌の予防効果を最大化することを目的としています。

参考文献

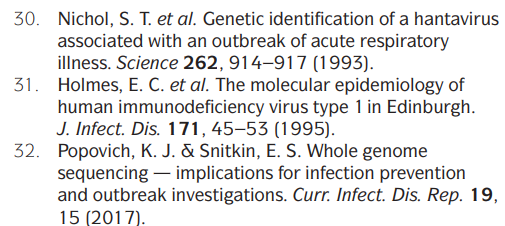

1. Chen Y, Padilla Aponte J, Wang K, Du M, Lu Y, Polychronidis G, Song M: Comparative risk of high-risk neoplasia after polypectomy among individuals aged below 50 years versus 50 years and older. Gut 2025;75:72-80. doi: 10.1136/gutjnl-2025-335275 PMID: 40850745 https://pubmed.ncbi.nlm.nih.gov/40850745/

2. Uchiyama T, Takahashi H, Endo H, Kato S, Sakai E, Hosono K, Yoneda M, Inamori M, Hippo Y, Nakagama H, Nakajima A: Number of aberrant crypt foci in the rectum is a useful surrogate marker of colorectal adenoma recurrence. Dig Endosc 2012;24:353-7. doi: 10.1111/j.1443-1661.2012.01289.x PMID: 22925289 https://pubmed.ncbi.nlm.nih.gov/22925289/

3. Rex DK, Kahi CJ, Levin B, Smith RA, Bond JH, Brooks D, Burt RW, Byers T, Fletcher RH, Hyman N, Johnson D, Kirk L, Lieberman DA, Levin TR, O’Brien MJ, Simmang C, Thorson AG, Winawer SJ: Guidelines for colonoscopy surveillance after cancer resection: a consensus update by the American Cancer Society and US Multi-Society Task Force on Colorectal Cancer. CA Cancer J Clin 2006;56:160-7 quiz 185-6. doi: 10.3322/canjclin.56.3.160 PMID: 16737948 https://pubmed.ncbi.nlm.nih.gov/16737948/

4. Winawer SJ, Zauber AG, Fletcher RH, Stillman JS, O’brien MJ, Levin B, Smith RA, Lieberman DA, Burt RW, Levin TR, Bond JH, Brooks D, Byers T, Hyman N, Kirk L, Thorson A, Simmang C, Johnson D, Rex DK: Guidelines for colonoscopy surveillance after polypectomy: a consensus update by the US Multi-Society Task Force on Colorectal Cancer and the American Cancer Society. CA Cancer J Clin 2006;56:143-59 quiz 184-5. doi: 10.3322/canjclin.56.3.143 PMID: 16737947 https://pubmed.ncbi.nlm.nih.gov/16737947/

5. Rex DK, Kahi CJ, Levin B, Smith RA, Bond JH, Brooks D, Burt RW, Byers T, Fletcher RH, Hyman N, Johnson D, Kirk L, Lieberman DA, Levin TR, O’Brien MJ, Simmang C, Thorson AG, Winawer SJ, American Cancer Society, US Multi-Society Task Force on Colorectal Cancer: Guidelines for colonoscopy surveillance after cancer resection: a consensus update by the American Cancer Society and the US Multi-Society Task Force on Colorectal Cancer. Gastroenterology 2006;130:1865-71. doi: 10.1053/j.gastro.2006.03.013 PMID: 16697749 https://pubmed.ncbi.nlm.nih.gov/16697749/

6. Bobay MC, Lahr RE, Shultz J, Vemulapalli KC, Guardiola JJ, Rex DK: Safety of first surveillance colonoscopy at 12 months after piecemeal EMR of large nonpedunculated colorectal lesions. Gastrointest Endosc 2024;100:905-913. doi: 10.1016/j.gie.2024.05.008 PMID: 38750975 https://pubmed.ncbi.nlm.nih.gov/38750975/

7. Sasson AN, Sheehan G, Yu A, Gupta A, Ling K, Kochar B, Ananthakrishnan AN: Yield and Predictors of Surveillance Colonoscopies in Older Adults With Long-standing Ulcerative Colitis. Clin Gastroenterol Hepatol 2022;20:e1353-e1364. doi: 10.1016/j.cgh.2021.08.019 PMID: 34425278 https://pubmed.ncbi.nlm.nih.gov/34425278/

8. Waldmann E, Kammerlander A, Gessl I, Penz D, Majcher B, Hinterberger A, Trauner M, Ferlitsch M: New risk stratification after colorectal polypectomy reduces burden of surveillance without increasing mortality. United European Gastroenterol J 2021;9:947-954. doi: 10.1002/ueg2.12119 PMID: 34343405 https://pubmed.ncbi.nlm.nih.gov/34343405/

9. Symonds E, Anwar S, Young G, Meng R, Coats M, Simpson K, Bampton P, Fraser R, Cock C: Sessile Serrated Polyps with Synchronous Conventional Adenomas Increase Risk of Future Advanced Neoplasia. Dig Dis Sci 2019;64:1680-1685. doi: 10.1007/s10620-019-5454-8 PMID: 30627918 https://pubmed.ncbi.nlm.nih.gov/30627918/

10. Jung YS, Kim NH, Park JH, Park DI, Sohn CI: Appropriate Surveillance Interval after Colonoscopic Polypectomy in Patients Younger than 50 Years. J Korean Med Sci 2019;34:e101. doi: 10.3346/jkms.2019.34.e101 PMID: 30940997 https://pubmed.ncbi.nlm.nih.gov/30940997/

11. Rutter MD, East J, Rees CJ, Cripps N, Docherty J, Dolwani S, Kaye PV, Monahan KJ, Novelli MR, Plumb A, Saunders BP, Thomas-Gibson S, Tolan DJM, Whyte S, Bonnington S, Scope A, Wong R, Hibbert B, Marsh J, Moores B, Cross A, Sharp L: British Society of Gastroenterology/Association of Coloproctology of Great Britain and Ireland/Public Health England post-polypectomy and post-colorectal cancer resection surveillance guidelines. Gut 2020;69:201-223. doi: 10.1136/gutjnl-2019-319858 PMID: 31776230 https://pubmed.ncbi.nlm.nih.gov/31776230/

12. Parker J, Gupta S, Torkington J, Dolwani S: Comparison of recommendations for surveillance of advanced colorectal polyps: A systematic review of guidelines. J Gastroenterol Hepatol 2023;38:854-864. doi: 10.1111/jgh.16157 PMID: 36823764 https://pubmed.ncbi.nlm.nih.gov/36823764/

13. Lee JK, Jensen CD, Levin TR, Doubeni CA, Zauber AG, Chubak J, Kamineni AS, Schottinger JE, Ghai NR, Udaltsova N, Zhao WK, Fireman BH, Quesenberry CP, Orav EJ, Skinner CS, Halm EA, Corley DA: Long-term Risk of Colorectal Cancer and Related Death After Adenoma Removal in a Large, Community-based Population. Gastroenterology 2020;158:884-894.e5. doi: 10.1053/j.gastro.2019.09.039 PMID: 31589872 https://pubmed.ncbi.nlm.nih.gov/31589872/

14. Butterly LF, Nadel MR, Anderson JC, Robinson CM, Weiss JE, Lieberman D, Shapiro JA: Impact of Colonoscopy Bowel Preparation Quality on Follow-up Interval Recommendations for Average-risk Patients With Normal Screening Colonoscopies: Data From the New Hampshire Colonoscopy Registry. J Clin Gastroenterol 2020;54:356-364. doi: 10.1097/MCG.0000000000001115 PMID: 30106836 https://pubmed.ncbi.nlm.nih.gov/30106836/

15. East JE, Atkin WS, Bateman AC, Clark SK, Dolwani S, Ket SN, Leedham SJ, Phull PS, Rutter MD, Shepherd NA, Tomlinson I, Rees CJ: British Society of Gastroenterology position statement on serrated polyps in the colon and rectum. Gut 2017;66:1181-1196. doi: 10.1136/gutjnl-2017-314005 PMID: 28450390 https://pubmed.ncbi.nlm.nih.gov/28450390/

16. Nakajima T, Sakamoto T, Hori S, Yamada S, Ikematsu H, Harada K, Chiu HM, Kiriyama S, Michida T, Hotta K, Sakamoto N, Abe T, Chino A, Fukuzawa M, Kobayashi N, Fukase K, Matsuda T, Murakami Y, Ishikawa H, Saito Y: Optimal surveillance interval after piecemeal endoscopic mucosal resection for large colorectal neoplasia: a multicenter randomized controlled trial. Surg Endosc 2022;36:515-525. doi: 10.1007/s00464-021-08311-6 PMID: 33569725 https://pubmed.ncbi.nlm.nih.gov/33569725/

17. Jung YS, Kim TJ, Nam E, Park CH: Comparative systematic review and meta-analysis of 1- to 5-mm versus 6- to 9-mm adenomas on the risk of metachronous advanced colorectal neoplasia. Gastrointest Endosc 2020;92:692-701.e2. doi: 10.1016/j.gie.2020.04.042 PMID: 32334021 https://pubmed.ncbi.nlm.nih.gov/32334021/

18. Cross AJ, Robbins EC, Pack K, Stenson I, Kirby PL, Patel B, Rutter MD, Veitch AM, Saunders BP, Duffy SW, Wooldrage K: Long-term colorectal cancer incidence after adenoma removal and the effects of surveillance on incidence: a multicentre, retrospective, cohort study. Gut 2020;69:1645-1658. doi: 10.1136/gutjnl-2019-320036 PMID: 31953252 https://pubmed.ncbi.nlm.nih.gov/31953252/

19. Wieszczy P, Kaminski MF, Franczyk R, Loberg M, Kobiela J, Rupinska M, Kocot B, Rupinski M, Holme O, Wojciechowska U, Didkowska J, Ransohoff D, Bretthauer M, Kalager M, Regula J: Colorectal Cancer Incidence and Mortality After Removal of Adenomas During Screening Colonoscopies. Gastroenterology 2020;158:875-883.e5. doi: 10.1053/j.gastro.2019.09.011 PMID: 31563625 https://pubmed.ncbi.nlm.nih.gov/31563625/

20. Tate DJ, Desomer L, Klein A, Brown G, Hourigan LF, Lee EY, Moss A, Ormonde D, Raftopoulos S, Singh R, Williams SJ, Zanati S, Byth K, Bourke MJ: Adenoma recurrence after piecemeal colonic EMR is predictable: the Sydney EMR recurrence tool. Gastrointest Endosc 2017;85:647-656.e6. doi: 10.1016/j.gie.2016.11.027 PMID: 27908600 https://pubmed.ncbi.nlm.nih.gov/27908600/

21. Kahi CJ, Boland CR, Dominitz JA, Giardiello FM, Johnson DA, Kaltenbach T, Lieberman D, Levin TR, Robertson DJ, Rex DK, United States Multi-Society Task Force on Colorectal Cancer: Colonoscopy Surveillance After Colorectal Cancer Resection: Recommendations of the US Multi-Society Task Force on Colorectal Cancer. Gastroenterology 2016;150:758-768.e11. doi: 10.1053/j.gastro.2016.01.001 PMID: 26892199 https://pubmed.ncbi.nlm.nih.gov/26892199/

22. Kahi CJ, Boland CR, Dominitz JA, Giardiello FM, Johnson DA, Kaltenbach T, Lieberman D, Levin TR, Robertson DJ, Rex DK: Colonoscopy Surveillance after Colorectal Cancer Resection: Recommendations of the US Multi-Society Task Force on Colorectal Cancer. Am J Gastroenterol 2016;111:337-46 quiz 347. doi: 10.1038/ajg.2016.22 PMID: 26871541 https://pubmed.ncbi.nlm.nih.gov/26871541/

23. Jover R, Bretthauer M, Dekker E, Holme Ø, Kaminski MF, Løberg M, Zauber AG, Hernán MA, Lansdorp-Vogelaar I, Sunde A, McFadden E, Castells A, Regula J, Quintero E, Pellisé M, Senore C, Kalager M, Dinis-Ribeiro M, Emilsson L, Ransohoff DF, Hoff G, Adami HO: Rationale and design of the European Polyp Surveillance (EPoS) trials. Endoscopy 2016;48:571-8. doi: 10.1055/s-0042-104116 PMID: 27042931 https://pubmed.ncbi.nlm.nih.gov/27042931/

24. Clark BT, Rustagi T, Laine L: What level of bowel prep quality requires early repeat colonoscopy: systematic review and meta-analysis of the impact of preparation quality on adenoma detection rate. Am J Gastroenterol 2014;109:1714-23 quiz 1724. doi: 10.1038/ajg.2014.232 PMID: 25135006 https://pubmed.ncbi.nlm.nih.gov/25135006/

25. Hassan C, Quintero E, Dumonceau JM, Regula J, Brandão C, Chaussade S, Dekker E, Dinis-Ribeiro M, Ferlitsch M, Gimeno-García A, Hazewinkel Y, Jover R, Kalager M, Loberg M, Pox C, Rembacken B, Lieberman D, European Society of Gastrointestinal Endoscopy: Post-polypectomy colonoscopy surveillance: European Society of Gastrointestinal Endoscopy (ESGE) Guideline. Endoscopy 2013;45:842-51. doi: 10.1055/s-0033-1344548 PMID: 24030244 https://pubmed.ncbi.nlm.nih.gov/24030244/

26. Leddin D, Enns R, Hilsden R, Fallone CA, Rabeneck L, Sadowski DC, Singh H, Canadian Association of Gastroenterology: Colorectal cancer surveillance after index colonoscopy: guidance from the Canadian Association of Gastroenterology. Can J Gastroenterol 2013;27:224-8. doi: 10.1155/2013/232769 PMID: 23616961 https://pubmed.ncbi.nlm.nih.gov/23616961/

27. Winawer SJ, Zauber AG, O’Brien MJ, Ho MN, Gottlieb L, Sternberg SS, Waye JD, Bond J, Schapiro M, Stewart ET: Randomized comparison of surveillance intervals after colonoscopic removal of newly diagnosed adenomatous polyps. The National Polyp Study Workgroup. N Engl J Med 1993;328:901-6. doi: 10.1056/NEJM199304013281301 PMID: 8446136 https://pubmed.ncbi.nlm.nih.gov/8446136/

28. Winawer SJ, Zauber AG, Fletcher RH, Stillman JS, O’brien MJ, Levin B, Smith RA, Lieberman DA, Burt RW, Levin TR, Bond JH, Brooks D, Byers T, Hyman N, Kirk L, Thorson A, Simmang C, Johnson D, Rex DK: Guidelines for colonoscopy surveillance after polypectomy: a consensus update by the US Multi-Society Task Force on Colorectal Cancer and the American Cancer Society. CA Cancer J Clin 2006;56:143-59 quiz 184-5. doi: 10.3322/canjclin.56.3.143 PMID: 16737947 https://pubmed.ncbi.nlm.nih.gov/16737947/

29. Cross AJ, Robbins EC, Pack K, Stenson I, Rutter MD, Veitch AM, Saunders BP, Duffy SW, Wooldrage K: Colorectal cancer risk following polypectomy in a multicentre, retrospective, cohort study: an evaluation of the 2020 UK post-polypectomy surveillance guidelines. Gut 2021;70:2307-2320. doi: 10.1136/gutjnl-2020-323411 PMID: 33674342 https://pubmed.ncbi.nlm.nih.gov/33674342/

30. Kim NH, Jung YS, Park JH, Park DI, Sohn CI: Risk of developing metachronous advanced colorectal neoplasia after colonoscopic polypectomy in patients aged 30 to 39 and 40 to 49 years. Gastrointest Endosc 2018;88:715-723. doi: 10.1016/j.gie.2018.05.018 PMID: 29857003 https://pubmed.ncbi.nlm.nih.gov/29857003/

31. Pinsky PF, Schoen RE: Contribution of Surveillance Colonoscopy to Colorectal Cancer Prevention. Clin Gastroenterol Hepatol 2020;18:2937-2944.e1. doi: 10.1016/j.cgh.2020.01.037 PMID: 32017987 https://pubmed.ncbi.nlm.nih.gov/32017987/

32. Gupta S, Earles A, Bustamante R, Patterson OV, Gawron AJ, Kaltenbach TR, Yassin H, Lamm M, Shah SC, Saini SD, Fisher DA, Martinez ME, Messer K, Demb J, Liu L: Adenoma Detection Rate and Clinical Characteristics Influence Advanced Neoplasia Risk After Colorectal Polypectomy. Clin Gastroenterol Hepatol 2023;21:1924-1936.e9. doi: 10.1016/j.cgh.2022.10.003 PMID: 36270618 https://pubmed.ncbi.nlm.nih.gov/36270618/

33. Tate DJ, Desomer L, Hourigan LF, Moss A, Singh R, Bourke MJ: Two-stage endoscopic mucosal resection is a safe and effective salvage therapy after a failed single-session approach. Endoscopy 2017;49:888-898. doi: 10.1055/s-0043-110671 PMID: 28564715 https://pubmed.ncbi.nlm.nih.gov/28564715/ 34. Klein A, Tate DJ, Jayasekeran V, Hourigan L, Singh R, Brown G, Bahin FF, Burgess N, Williams SJ, Lee E, Sidhu M, Byth K, Bourke MJ: Thermal Ablation of Mucosal Defect Margins Reduces Adenoma Recurrence After Colonic Endoscopic Mucosal Resection. Gastroenterology 2019;156:604-613.e3. doi: 10.1053/j.gastro.2018.10.003 PMID: 30296436 https://pubmed.ncbi.nlm.nih.gov/30296436/